Solución de problemas: El mapa del sitio de publicaciones no muestra páginas en RankMath

Puntos clave

- Un mapa del sitio de publicaciones es esencial para el SEO, ya que ayuda a los motores de búsqueda como Google a comprender e indexar el contenido de tu sitio.

- RankMath es un potente complemento de SEO para WordPress que facilita la creación y el envío de mapas del sitio.

- Si tu mapa del sitio de publicaciones no muestra todas tus páginas, hay pasos de solución de problemas que puedes seguir.

- Las causas comunes incluyen conflictos con otros complementos, configuraciones incorrectas y problemas de almacenamiento en caché.

- Esta guía ofrece un enfoque paso a paso para diagnosticar y resolver problemas comunes en el mapa del sitio de publicaciones de RankMath.

Introducción

En el mundo del SEO, un mapa del sitio es como un mapa para los motores de búsqueda. Les ayuda a encontrar todas las páginas de tu sitio. RankMath es un conocido complemento de SEO para WordPress que facilita la creación y gestión de estos mapas del sitio. Sin embargo, a veces, el mapa del sitio de publicaciones en RankMath puede no mostrar todas tus páginas en Google Search Console. Este problema puede deberse a conflictos con el complemento de caché, lo que reduce la visibilidad de tu sitio en Google. Esta guía detallada te ayudará a solucionar los problemas con el mapa del sitio de publicaciones en RankMath.

¿Qué es un mapa del sitio (Sitemap) de Google?

Un mapa del sitio de Google es un archivo que enumera todas las URL de un sitio web, lo que ayuda a los motores de búsqueda como Google a rastrear e indexar el contenido de manera eficiente. Este archivo XML, generado específicamente para los motores de búsqueda, proporciona información valiosa sobre cada página, como la última vez que se actualizó y su importancia en relación con otras páginas del sitio. Al enviar un mapa del sitio a Google Search Console mediante FTP, los propietarios de sitios web pueden asegurarse de que sus páginas se descubran e incluyan rápidamente en los resultados de búsqueda.

¿Qué es Google Search Console?

Google Search Console es una herramienta gratuita proporcionada por Google que ayuda a los propietarios de sitios web a monitorear, mantener y solucionar problemas relacionados con la presencia de su sitio en los resultados de búsqueda de Google. Ofrece información sobre cómo Google ve tu sitio, identifica y soluciona problemas que afectan su visibilidad, y proporciona datos sobre el tráfico y el rendimiento de búsqueda. Al analizar palabras clave, clics e impresiones, los propietarios pueden optimizar su contenido para mejorar el posicionamiento en los motores de búsqueda y la experiencia del usuario.

Cómo usar Search Console

Para utilizar Search Console de manera efectiva, accede a la plataforma y selecciona tu propiedad. Haz clic en la pestaña “Índice” para inspeccionar las páginas indexadas y descubrir cuáles faltan. Usa el “Informe de cobertura” para identificar problemas de indexación y solucionarlos rápidamente. Además, explora la herramienta “Inspección de URL” para depurar URL específicas y solicitar la indexación de contenido nuevo o actualizado, asegurándote de eliminar cualquier información personal si es necesario. Monitorear Search Console regularmente puede optimizar la visibilidad y el rendimiento de tu sitio en los motores de búsqueda.

Cómo identificar páginas que aún no están en Google con Search Console

Para identificar páginas que aún no están en Google mediante Search Console, accede al informe “Cobertura del índice”. Busca páginas marcadas como “Excluidas” para ver cuáles no han sido indexadas. Filtra por “URL enviada no seleccionada como canónica” para detectar problemas de canonización. Revisa las páginas etiquetadas como “Indexadas, no enviadas en el mapa del sitio” para identificar aquellas que se han indexado sin estar en el mapa del sitio. Utiliza la sección “Problemas de cobertura” para obtener información más detallada sobre los problemas de indexación. Al revisar estas secciones, podrás detectar y corregir problemas de indexación de manera eficiente.

Cómo usar Search Console para indexar una página

Para indexar una página con Search Console, usa la herramienta “Inspección de URL”, ingresa la URL y haz clic en “Solicitar indexación”. Supervisa el estado para detectar errores o problemas. Si la página no se indexa, soluciona posibles inconvenientes verificando las etiquetas meta robots, asegurándote de que la página no tenga la etiqueta “noindex” y comprobando que la URL sea accesible. Utiliza la opción “Inspeccionar URL” para un análisis detallado y, si es necesario, solicita la indexación para que Google rastree e indexe la página rápidamente.

Comprendiendo los mapas del sitio de publicaciones en RankMath

Un mapa del sitio de publicaciones es un archivo XML especial que muestra todas las publicaciones de tu sitio web. También incluye detalles importantes, como la fecha de publicación y la frecuencia de actualización. RankMath facilita la creación de este mapa del sitio de manera automática, sin necesidad de hacerlo manualmente. Después de crearlo, debes enviarlo a los motores de búsqueda para que encuentren y cataloguen tu contenido de manera eficiente.

¿Qué es RankMath y cómo mejora el SEO?

RankMath es un potente complemento de WordPress que ayuda a mejorar el SEO de tu sitio web. Cuenta con muchas funciones útiles, como análisis de SEO en la página, optimización de palabras clave y marcado de esquema. También genera mapas del sitio. Con RankMath, puedes simplificar las tareas de SEO, lo que facilita que los motores de búsqueda encuentren tu sitio.

La importancia de los mapas del sitio de publicaciones para una indexación rápida

La indexación rápida es clave para que tu contenido nuevo o actualizado llegue a tu audiencia rápidamente. Un mapa del sitio de publicaciones ayuda al conectar directamente tu sitio web con los motores de búsqueda. Cuando envías un mapa del sitio de publicaciones, informas a los motores de búsqueda sobre el nuevo contenido. Si aún necesitas ayuda con la indexación, puedes abrir un nuevo ticket de soporte. Esto hará que los motores de búsqueda rastreen e indexen tu contenido más rápido, logrando que aparezca antes en las páginas de resultados (SERPs).

Guía para principiantes para diagnosticar problemas con el mapa del sitio de publicaciones

Solucionar problemas técnicos puede parecer complicado al principio. Sin embargo, seguir un plan simple puede hacerlo mucho más fácil. Primero, veamos qué herramientas y recursos necesitarás.

Equipos y recursos necesarios para la solución de problemas

Antes de comenzar con la solución de problemas, asegúrate de tener lo siguiente:

- Acceso a tu panel de WordPress: Desde aquí puedes gestionar tus complementos y configuraciones.

- Una cuenta en Google Search Console: Esta herramienta gratuita te ayuda a ver cómo Google visualiza tu sitio.

- Acceso al servidor de tu sitio web: Puede ser necesario para resolver problemas más complejos relacionados con la configuración del servidor.

- Canales de soporte: Puedes solicitar ayuda al equipo de soporte de RankMath, en su foro técnico o en su base de conocimientos.

Paso 1: Verificar tu sitio con Google Search Console

Lo primero que debes hacer es verificar tu sitio web con Google Search Console. Esta herramienta te proporciona información clave sobre el estado de tu mapa del sitio. Si aún no lo has hecho, sigue las instrucciones de Google para verificar tu sitio.

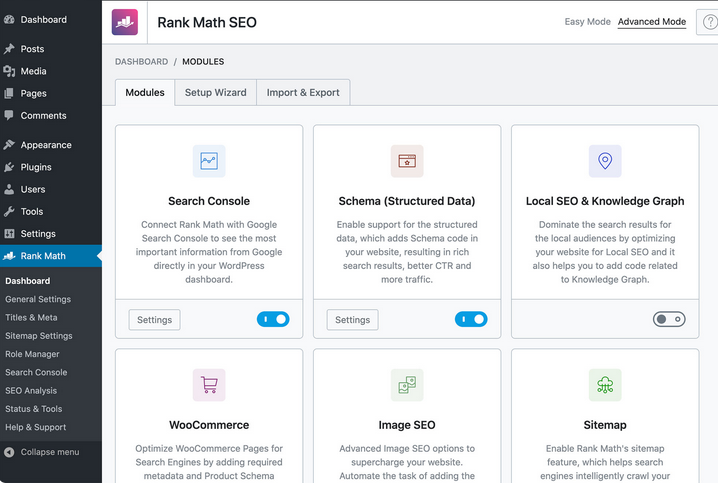

Paso 2: Revisar la configuración del mapa del sitio en RankMath

Dirígete a la sección “Ajustes del mapa del sitio” dentro del complemento RankMath en el panel de WordPress. Revisa cuidadosamente la configuración. Asegúrate de que los tipos de publicaciones estén incluidos en el mapa del sitio. También verifica la pestaña “Avanzado” para detectar exclusiones o configuraciones personalizadas que puedan estar afectando tu mapa del sitio.

Razones comunes por las que el mapa del sitio de publicaciones no muestra páginas

Ahora que tienes las herramientas necesarias, analicemos algunas razones comunes por las que un mapa del sitio de publicaciones podría no mostrar todas las páginas:

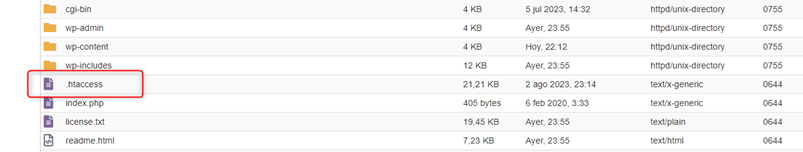

Configuración incorrecta del mapa del sitio en RankMath

Una posibilidad es que la configuración de tu mapa del sitio en RankMath no esté bien ajustada. Asegúrate de haber activado la opción “Incluir publicaciones y taxonomías en el mapa del sitio”. Verifica que no hayas excluido accidentalmente ningún tipo de publicación o página específica. Además, revisa tus enlaces permanentes para asegurarte de que sean correctos. Las reglas de reescritura incorrectas pueden afectar la generación del mapa del sitio.

Conflicto con otros complementos de SEO o temas

Pueden ocurrir conflictos entre RankMath y otros complementos de SEO o incluso con tu tema de WordPress. Si tienes otros complementos de SEO instalados, intenta desactivarlos temporalmente para ver si el problema desaparece. También puedes cambiar a un tema predeterminado de WordPress por un momento. Esto puede ayudarte a determinar si tu tema está causando el problema. Si sigues experimentando inconvenientes, revisa el archivo de tickets de soporte para encontrar soluciones comunes.

Conclusión

En conclusión, solucionar problemas con tu mapa del sitio en RankMath requiere atención cuidadosa y un plan claro. Primero, verifica tu sitio con Google Search Console. Luego, revisa la configuración del mapa del sitio en RankMath. De esta manera, podrás identificar y corregir problemas comunes en el mapa del sitio.

Es importante recordar que los mapas del sitio de publicaciones ayudan a que tu sitio se indexe rápidamente, lo cual es clave para un buen rendimiento en SEO. Asegúrate de detectar cualquier problema con RankMath, otros complementos de SEO o tu tema de WordPress. Siguiendo estos pasos, podrás optimizar la configuración de tu mapa del sitio y mejorar la visibilidad de tu sitio en los motores de búsqueda.

Preguntas Frecuentes

¿Cómo envío mi mapa del sitio a Google Search Console?

Simplemente inicia sesión en tu cuenta de Google Search Console. Luego, busca la sección “Sitemaps”. Ingresa la URL de tu mapa del sitio, que normalmente es ‘tusitio.com/sitemap_index.xml’. Después, haz clic en “Enviar”.

¿Puedo excluir páginas específicas del mapa del sitio en RankMath?

Sí, con RankMath puedes elegir excluir páginas específicas o incluso tipos de publicaciones enteros de tu mapa del sitio. Puedes configurar estas exclusiones en la sección “Ajustes del mapa del sitio”.

¿Por qué Google no está indexando mi mapa del sitio?

Hay varias razones por las que Google puede no estar indexando tu sitio en un servidor Nginx. Algunas causas comunes incluyen:

- La presencia de una etiqueta “noindex” en tus páginas.

- Reglas incorrectas en el archivo robots.txt.

- Un mapa del sitio nuevo que Google aún no ha revisado.

¿Con qué frecuencia RankMath actualiza mi mapa del sitio?

RankMath actualiza automáticamente tu mapa del sitio cada vez que hay cambios en el contenido de tu sitio web. Sin embargo, la frecuencia de actualización también puede depender de la configuración de caché que tengas activada.

¿Qué hace que RankMath sea diferente de otros complementos de SEO?

RankMath se destaca por su facilidad de uso, la gran cantidad de funciones que ofrece y su enfoque en proporcionar herramientas avanzadas de SEO de forma gratuita. Muchos otros complementos solo incluyen estas herramientas en sus planes de pago.

Si te gustó este artículo, suscríbete a nuestro canal de YouTube para videos tutoriales de Hosting, prácticas y demás. También puede encontrarnos en Twitter, Facebook e Instagram.